随着企业数据规模的爆炸式增长,如何实现异构数据源之间的高效迁移成为技术团队的核心需求。本文将全面解析阿里巴巴开源的DataX工具,从软件下载、环境配置到实战应用,提供一站式解决方案。您将掌握Windows/Linux双平台安装技巧、JSON任务配置规范,以及MySQL到HDFS等典型场景的同步案例,帮助您快速完成TB级数据迁移任务,提升企业数据治理效率。

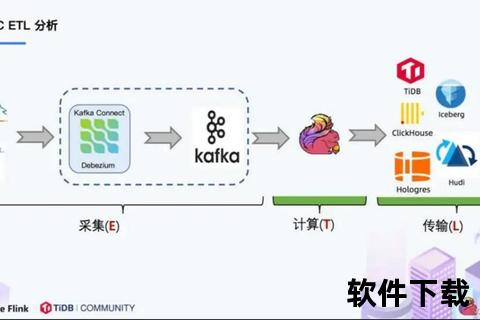

DataX是阿里巴巴集团研发的离线数据同步工具,支持包括MySQL、Oracle、HDFS、Hive等40+种数据源的异构迁移。其采用星型架构设计,通过Reader和Writer插件实现不同数据源的解耦对接,相较于传统ETL工具具有三大优势:一是单机多线程架构支持10MB/s以上的同步速度;二是JSON配置方式简化任务开发流程;三是完善的错误重试机制保障数据完整性。

访问DataX官网或阿里云镜像源获取最新安装包。Windows用户推荐下载预编译版本(约85MB),Linux用户可选择源码编译方式获得定制化功能。

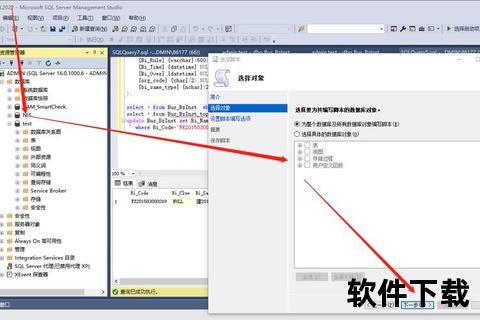

Windows环境部署:

Linux环境部署:

解压安装包

tar -zxvf datax.tar.gz -C /opt/module/

验证安装

cd /opt/module/datax/bin && python datax.py ../job/job.json

出现"任务总计耗时"日志即表示环境配置成功。

通过命令行生成配置模板可大幅提升开发效率,执行命令:

python datax.py -r {reader插件名} -w {writer插件名}

示例:生成MySQL到HDFS模板

python datax.py -r mysqlreader -w hdfswriter

该命令将输出包含连接参数、字段映射等完整配置框架,用户只需修改具体参数即可。

| 模块 | 参数 | 说明 |

|---|---|---|

| Reader | jdbcUrl | 源数据库连接地址,格式:jdbc:mysql://ip:port/db |

| splitPk | 数据分片字段,推荐使用自增主键 | |

| queryTimeout | 查询超时设置(单位:秒) | |

| Writer | writeMode | 写入模式:insert/replace/update |

| batchSize | 批量提交条数(建议1000-5000) | |

| compress | HDFS压缩格式:gzip/bzip2等 |

特别提醒:字段映射需确保源库与目标库的列顺序、数据类型严格匹配。

以迁移用户表(user_info)为例,配置文件核心参数如下:

job": {

content": [{

reader": {

name": "mysqlreader",

parameter": {

username": "root",

password": "",

column": ["id","name","reg_date"],

connection": [{

jdbcUrl": ["jdbc:mysql://192.168.1.100:3306/source_db"],

table": ["user_info"]

}]

},

writer": {

name": "hdfswriter",

parameter": {

path": "/datax/user_info/${dt}",

fileName": "user_",

fieldDelimiter": "

fileType": "text

}],

setting": {

speed": {"channel": 4}

执行命令:python datax.py mysql2hdfs.json 可完成日均千万级数据迁移。

当需要从SQL Server迁移至MySQL时,需特别注意类型转换:

通过配置预处理SQL可实现自动类型转换:

preSql": ["ALTER TABLE %s MODIFY COLUMN content LONGTEXT"]

通过where条件过滤实现增量同步:

where": "update_time > '${last_sync_time}'

配合Linux定时任务(crontab)可实现小时级数据同步,建议配合时间戳字段建立索引提升查询效率。

对于PB级数据迁移,可通过以下方式提升性能:

实测表明,16核服务器配置16个channel时,同步速度可达50MB/s。

| 错误类型 | 解决方案 |

|---|---|

| Python版本不兼容 | 安装Python2.6.x并配置环境变量 |

| 中文字段乱码 | 执行CHCP 65001切换控制台编码 |

| OOM内存溢出 | 修改datax.py的jvm参数为-XX:+UseG1GC |

| 网络连接超时 | 调整queryTimeout至300秒以上 |

更多故障解决方案可参考DataX官方GitHub的issue记录。

DataX支持通过插件机制扩展数据源,开发新插件需完成:

已有社区贡献的Cassandra、Kafka等20+扩展插件,可通过DataX-web可视化平台进行任务调度。

通过本指南的系统学习,您已掌握DataX工具从环境搭建到生产部署的全链路技能。建议结合官方文档进行深度实践,关注阿里云DataWorks集成方案获取企业级支持。定期检查数据校验报告,建立完善的数据迁移SOP流程,让数据真正成为企业的核心资产。